©作者 | 美索不达米亚平原

单位 | 清华大学、字节跳动

本文介绍我们ECCV 2022关于知识蒸馏的工作: Masked Generative Distillation,方法适用于分类,检测与分割任务。现在代码已经开源,欢迎大家使用。

论文标题:

Masked Generative Distillation

收录会议:

ECCV 2022

论文链接:

https://arxiv.org/abs/2205.01529

代码链接:

https://github.com/yzd-v/MGD

简介

知识蒸馏主要可以分为 logit 蒸馏和 feature 蒸馏。其中 feature 蒸馏具有更好的拓展性,已经在很多视觉任务中得到了应用。但由于不同任务的模型结构差异,许多 feature 蒸馏方法是针对某个特定任务设计的。

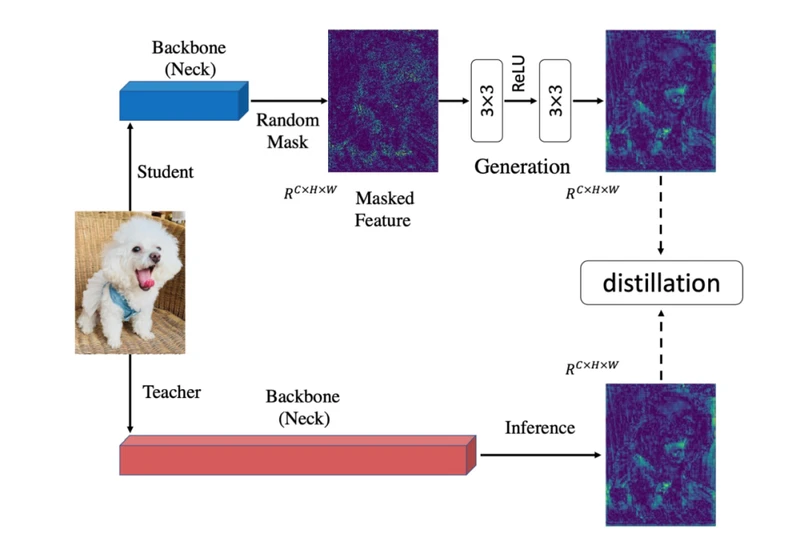

之前的知识蒸馏方法着力于使学生去模仿更强的教师的特征,以使学生特征具有更强的表征能力。我们认为提升学生的表征能力并不一定需要通过直接模仿教师实现。从这点出发,我们把模仿任务修改成了生成任务:让学生凭借自己较弱的特征去生成教师较强的特征。在蒸馏过程中,我们对学生特征进行了随机 mask,强制学生仅用自己的部分特征去生成教师的所有特征,以提升学生的表征能力。

为了证明 MGD 并不是通过模仿教师来提升学生,我们对学生和教师的特征图进行了可视化。可以看到,蒸馏前的学生与教师的注意力相差很大。在使用 FGD 蒸馏(模仿教师)后,学生的注意力和教师变得很接近,表现也得到了较大的提升。但当使用 MGD 蒸馏后,学生与教师差异很大,学生对于背景的响应大幅减小,对于目标的响应得到了增强,学生的最终表现也好于 FGD 蒸馏。

整体框架

MGD 是在 feature 层面的蒸馏,可以很方便地被应用到不同任务,如分类,检测与语义分割。

实验结果

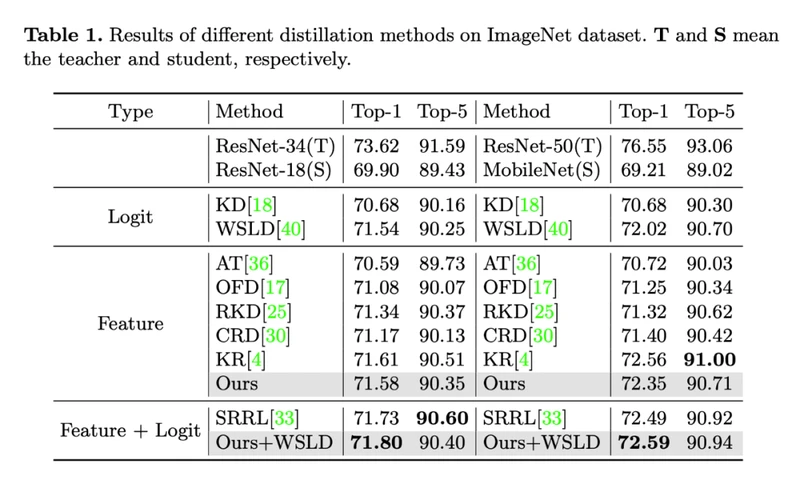

3.1 图像分类

我们首先在图像分类任务上进行实验,在 pixel 层面进行随机 mask,学生模型在 ImageNet 上获得了有效的提升。并且可以和 logit 蒸馏进行叠加,进一步提升学生模型。

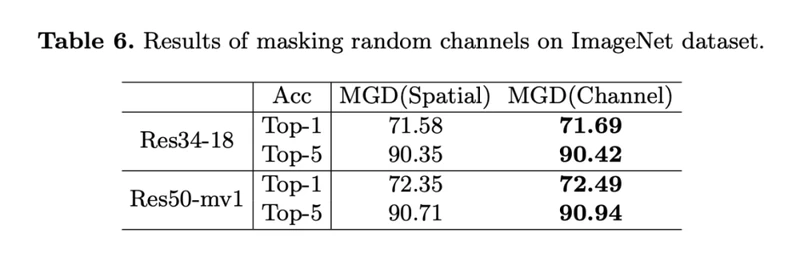

对于分类任务而言,常常会对特征进行 pixel 层面的池化,模型对于 channel 维度更加敏感。所以我们还在 channel 维度进行了随机 mask,学生模型可以获得更大的提升,在 feature 蒸馏方法中实现了 SOTA。

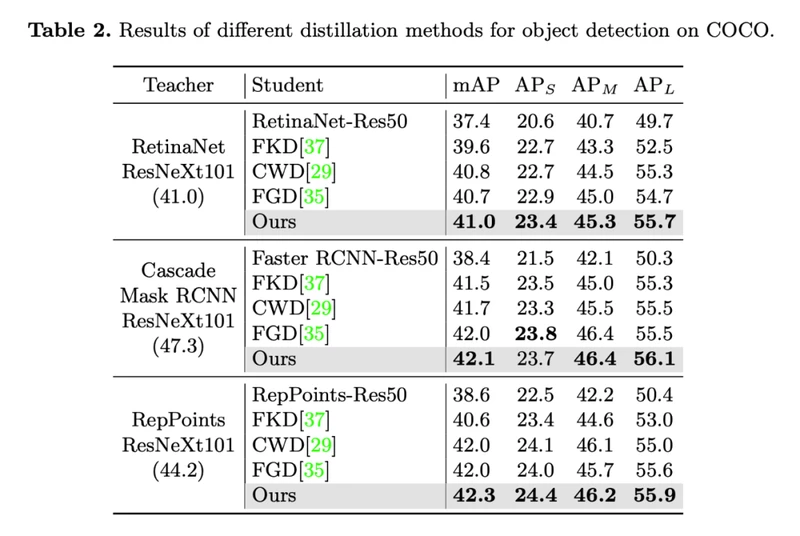

3.2 密集预测

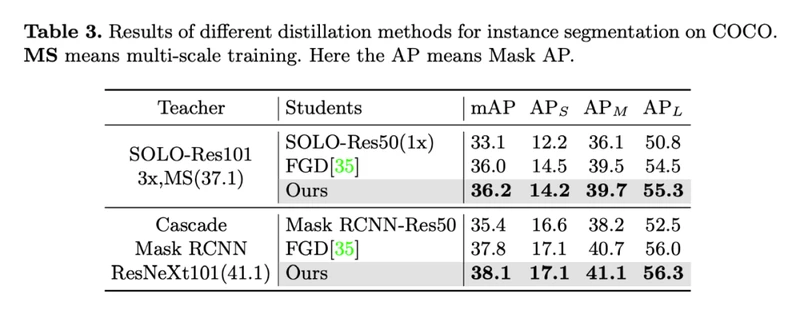

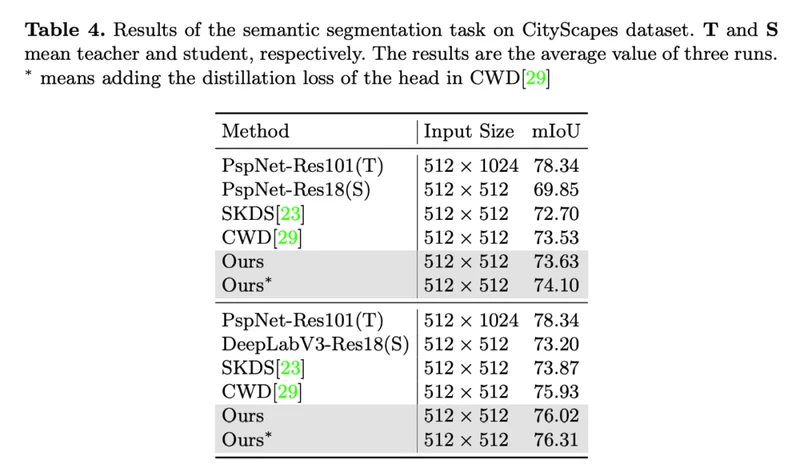

我们也将 MGD 应用到了目标检测,实例分割与语义分割任务上,分别在 COCO 和 CityScapes 进行实验,学生模型均获得了大幅的提升。

分析

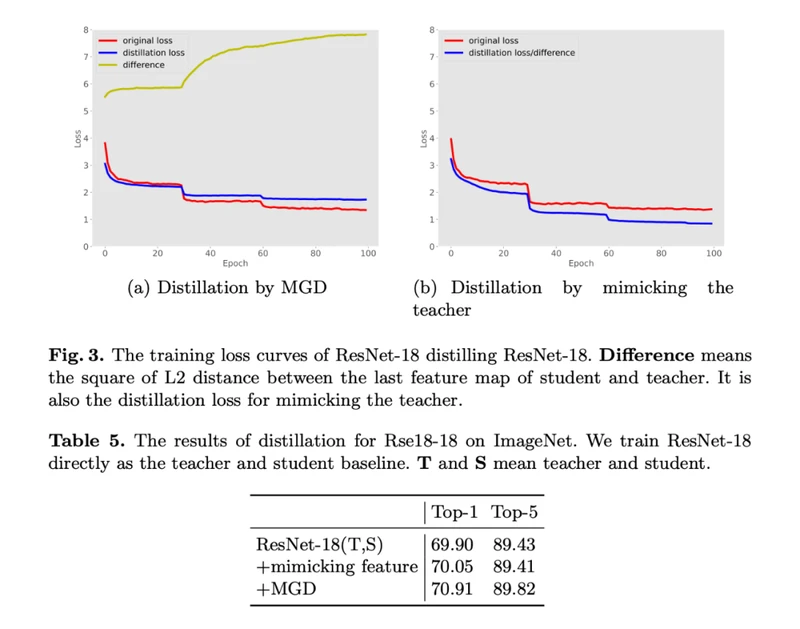

为了进一步证明 MGD 通过生成的方法提升学生的表征能力,我们在分类任务上与直接模仿教师的方法进行了对比。此处蒸馏使用直接训练得到的学生模型作为老师,可以看到,即便是学生自己作为老师,MGD 也能为学生带来有效的提升,而直接模仿教师对于学生的提升非常小。

代码与更多蒸馏

我们已将代码开源:

https://github.com/yzd-v/MGD

开源代码中放了蒸馏的学生模型和训练 log。三种任务的代码均基于 MMLab 的工具实现,易于复现,MGD 仅有两个超参,方便自由组合学生与教师进行蒸馏。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·