简介

RDMA

全称是Remote Direct Memory Access,即远程直接内存访问,是一种用于高性能网络通信的技术。RDMA技术可以让计算机直接访问远程计算机的内存,而无需在本地和远程计算机之间进行数据复制。

相比传统的网络通信方式,RDMA技术具有更低的延迟、更高的带宽和更低的CPU利用率等优点,可以显著提高网络通信的性能和效率。目前支持RDMA的网络协议主要有:InfiniBand(IB)、ROCE、iWARP。

IB网络

主要用于高性能计算(HPC)场景,通过高速的InfiniBand技术,将业务负载由单机运行转化为基于多机协作的高性能计算集群。

IB相比以太网的优势有:

- 高带宽、低延时

- CPU卸载

- 简单的网络管理

- 稳定性

- SHARP网络计算

GPU集群

随着模型复杂程度增加,单张GPU无法完成训练任务,需要联合多张GPU,乃至多台服务器搭建集群协同工作,并需要GPU之间以及服务器之间进行数据传输交互。在传统的方案中,GPU互联通常采用PCIe,服务器之间互联采用以太网Ethernet。

为了实现极限的超高计算密度,英伟达推出NVLink技术代替传统的PCIe技术,相较采用PCIe,NVLink技术带宽增加5倍。除能够实现GPU间高速内部通信的NVLink技术外,还可以用InfiniBand代替Ethernet,为系统和系统间通信提供更大带宽,减少数据传输延迟造成的瓶颈。

NVIDIA相继推出了InfiniBand 100G EDR、200G HDR以及400G NDR的解决方案。

IB交换机

Quantum系列盒式交换机

Quantum系列盒式交换机有QM8700和QM8790两种,两种型号交换机区别在管理方式上,QM8700有control口支持带外管理,QM8790则需要NVIDIA Unified Fabric Manager (UFM) platform进行管理。

QM8700前面板

QM8790前面板

QM8700&QM8790后面板

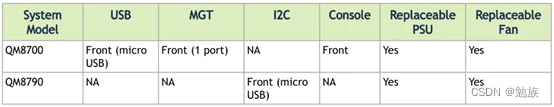

QM8700&QM8790管理口

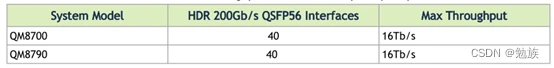

QM8700&QM8790 接口速率及最大吞吐量

QM8700&QM8790 端口拆分

QM8700系列盒式交换机有40个200G QSFP56端口,最多可拆分为80个HDR 100G端口用来下连100G HDR网卡,同时每个端口也支持EDR,与EDR的网卡直连,但是200G HDR端口只能降速至100G与EDR网卡互联,无法拆分为2X100G连接两张EDR网卡。

型号

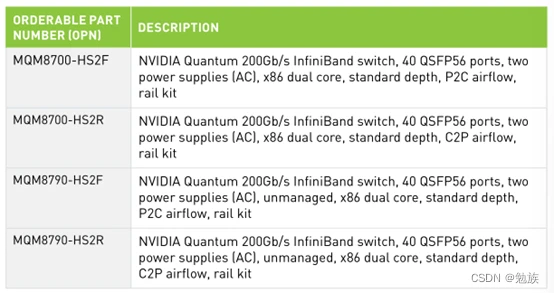

对于QM8700和QM8790,每个型号的交换机都有两种风向选择,例如:8790-HS2F为 P2C airflow(前后风道) 风扇模块上蓝色标记,8790-HS2R为 C2P airflow(后前风道)风扇模块上红色标记。这里P2C和C2P中 P表示Power电源,C表示Cable(线路接口),P2C(Power to Cable),C2P(Cable to Power )这里参照系是Power电源侧为前,Cable线路接口侧为后。

QM8700系列盒式交换机有40个200G QSFP56端口,最多可拆分为80个HDR 100G端口用来下连100G HDR网卡,同时每个端口也支持EDR,与EDR的网卡直连,但是200G HDR端口只能降速至100G与EDR网卡互联,无法拆分为2X100G连接两张EDR网卡。

型号

对于QM8700和QM8790,每个型号的交换机都有两种风向选择,例如:8790-HS2F为 P2C airflow(前后风道) 风扇模块上蓝色标记,8790-HS2R为 C2P airflow(后前风道)风扇模块上红色标记。这里P2C和C2P中 P表示Power电源,C表示Cable(线路接口),P2C(Power to Cable),C2P(Cable to Power )这里参照系是Power电源侧为前,Cable线路接口侧为后。

Quantum-2系列盒式交换机

Quantum-2 InfiniBand交换机主芯片采用7纳米制程,包含了570亿个晶体管,略多于含有540亿个晶体管的NVIDIA A100 GPU。Quantum-2系列盒式交换机有QM9700和QM9790,具有32个800G物理接口,支持64个NDR 400Gb/s InfiniBand端口(可拆分多达128个 200Gb/s端口)在交换能力上超出上一代Quantum-1约5倍。两种型号交换机区别在管理方式上不同。

QM9700前面板

QM9790前面板

QM9700&QM9790后面板

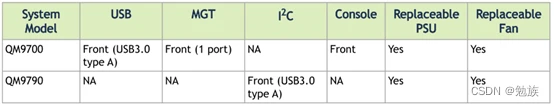

QM9700&QM9790管理口

QM9700&QM9790交换机接口速率及最大吞吐量

QM9700&QM9790端口拆分

32个OSFP端口可拆分为64个NDR 400G端口,每个NDR端口也可以一分为二。

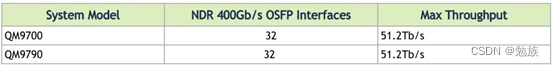

型号

网卡

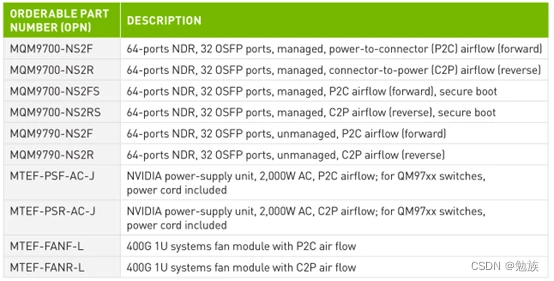

HDR网卡

在速率上有两种选择HDR100与HDR,其中HDR100网卡支持100G的传输速率,2个HDR100端口可通过200G to 2X100G线缆与HDR交换机互联。与100G EDR网卡不同,HDR100网卡的100G端口既支持4X25G NRZ传输,也支持2X50G PAM4传输。HDR网卡支持200G的传输速率,可直接使用200G直连线缆与交换机互联。

ConnectX-6网卡提供200Gb/s吞吐量,端到端延时低于600ns,向后兼容,支持HDR、HDR100、EDR、FDR、QDR、DDR和SDR InfiniBand以及200、100、50、40、25和10GbE。

NDR网卡

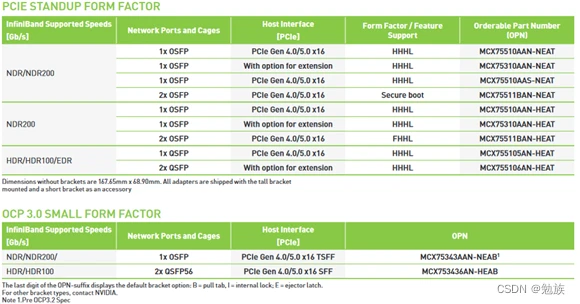

NVIDIA Quantum-2平台在主机端提供了两个网络选项,NVIDIA ConnectX-7网卡和NVIDIA BlueField-3 DPU InfiniBand。

NVIDIA ConnectX-7基于7纳米工艺设计,包含80亿个晶体管,可提供400Gb/s数据吞吐量,并支持32条PCIe Gen5或Gen4通道用于主机连接,其数据传输速率是NVIDIA ConnectX-6的两倍,还将RDMA、GPUDirect Storage、GPUDirect RDMA和网络计算的性能翻倍。

LinkX InfiniBand光连接件

InfiniBand光连接方案,包括使用单模和多模收发器、MPO光纤跳线、有源铜缆(ACC)和无源铜缆(DAC),用以满足搭建各种网络拓扑的需要。

HDR

100G速率既有100G EDR方案,也有100G HDR方案;200速率也有HDR和200G NDR两种选择,不同的方案下使用到的网卡、连接件、交换机都有较大区别。

NDR

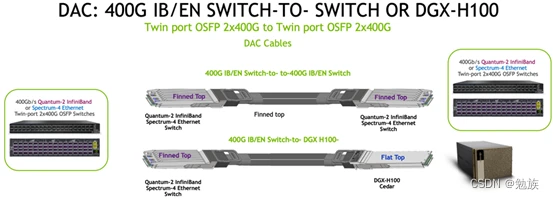

交换机互连

在交换机互连上,可选择采用全新OSFP封装 2xNDR (800Gbps) 光模块进行两台QM97XX交换机的互连,带鳍的设计,可以大大提高光模块散热性。

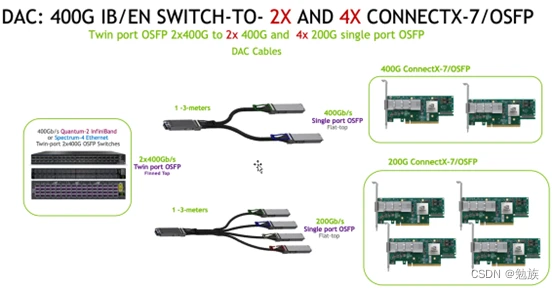

交换机和HCA互连

交换机和HCA的互联上,交换机端采用OSFP封装2xNDR (800Gbps)带鳍光模块,网卡端采用带有扁平OSFP 400Gbps光模块,MPO光纤跳线可提供3-150米,一对二分光器光纤可提供3-50米。

交换机到HCA的连接也提供DAC(最长1.5米)或者ACC(最长3米)的解决方案,一对二式分接线缆可用于交换机的一个OSFP端口(配备两个400Gb/s InfiniBand端口)和两个独立的400Gb/s HCA。一分四式分接线缆可用于连接交换机的一个OSFP交换机端口和四个200Gb/s HCA。

DGX A100 HDR 架构

A100 规格:

Eight NVIDIA A100 GPUs.

40 GB or 80 GB GPU memory options.

Six NVIDIA NVSwitch™ chips.

Dual AMD EPYC™ 7742 CPUs, 128 total cores, 2.25 GHz (base), 3.4 GHz (max boost).

Up to 2 TB of system memory.

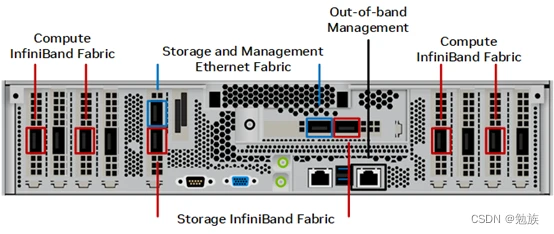

Eight NVIDIA ConnectX-6 or ConnectX-7 InfiniBand HCAs.

Two 1.92 TB M.2 NVMe drives for DGX OS, eight 3.84 TB U.2 NVMe drives for

storage/cache.

6.5 kW max power.

DGX A100 端口面板:

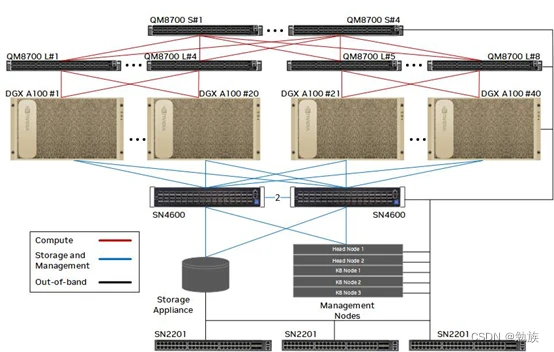

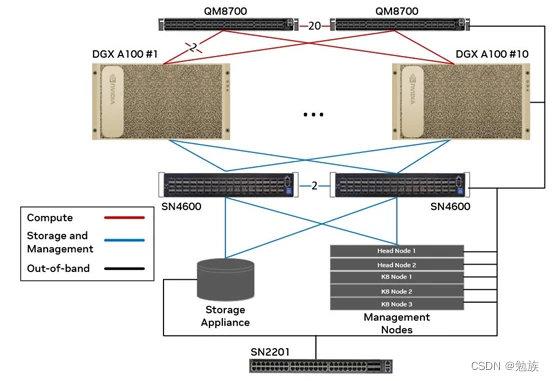

DGX BasePOD A100方案

DGX BasePOD方案中A100使用4x200G连接到计算IB Fabric,2x200G连接存储&管理以太网Fabric,带外管理接入单独的OOB以太网网络,IB交换机胖树组网,收敛比1:1。

部署10-40台A100节点,5台x86服务器部署管理节点。

如果10台以内A100节点,只有两台Leaf交换机互连即可,收敛比1:1。

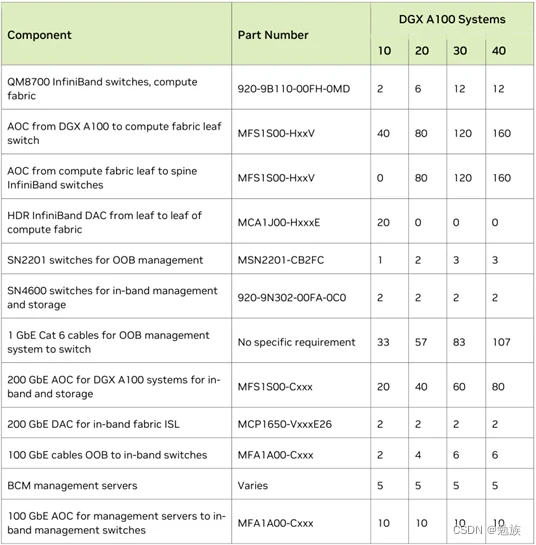

耗材清单:

DGX H100 NDR200架构

H100 规格:

Eight NVIDIA H100 GPUs.

80 GB GPU memory.

Four NVIDIA NVSwitch™ chips.

Dual 56-core fourth Gen Intel® Xeon® capable processors with PCIe 5.0 support.

2 TB of DDR5 system memory.

Four OSFP ports serving eight single-port NVIDIA ConnectX-7 VPI, three dual-port

NVIDIA ConnectX-7 VPI.

Two 1.92 TB M.2 NVMe drives for DGX OS, eight 3.84 TB U.2 NVMe drives for

storage/cache.

11.3 kW max power.

H100 端口面板:

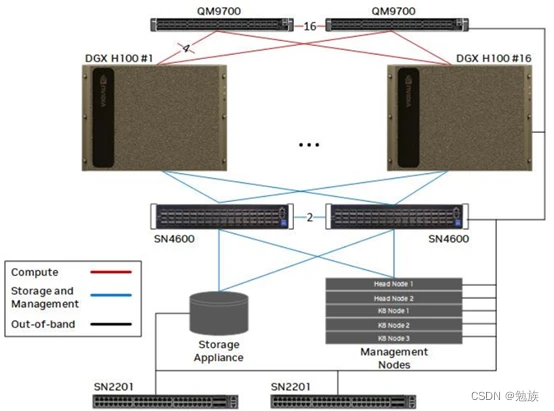

DGX BasePOD H100方案

DGX BasePOD 方案中,QM9700之间16x800G(NDR)互连,每个H100 8x200G接入IB计算Fabric,2x200G连接存储&管理以太网Fabric,带外管理接入单独的OOB以太网网络。

部署16台H100节点,5台x86服务器部署管理节点。

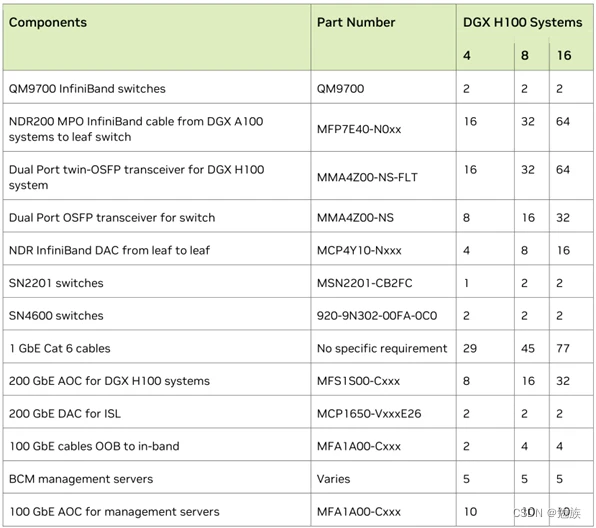

耗材清单: